瘍雯新闻网

文|数据猿

文|数据猿

从2024年最先,AI圈最抢手的话题中,视频天生模型肯定占一席之地。从OpenAI推出视频模型产品Sora一记重拳冷艳表态,到国内AI视频天生大模型井喷,AI视频天生已成为科技巨子和创业公司必争之地。

毫无疑问,AI视频天生对内容创作、媒体临盆乃至社会认知都会产生深远影响。只管被市场寄予厚望,但现在AI视频天生开发面临高成本、高难度、实用性差的痛点,真正贸易化非一日之功。

现在,市场上支流AI视频天生模型赛道有哪些玩家,其技术门路和产品能力怎样,数据猿选取国内外AI视频天生模型代表,从技术解读到实测效果,为人人周全浮现AI视频天生的现状。

技术面前没有魔法

AI视频天生逻辑底座解读

2024岁首年月,OpenAI发布了Sora技术演示视频,瞬间引爆全网。那些流畅自然、细节丰富的短视频,让人险些难以判袂真假。相较于2022年DALL-E和Midjourney引发的AI绘画海潮,Sora掀起的这波AI视频风暴,似乎来得更剧烈、更具颠覆性。

展开剩余 96 %但现实上,Sora爆火之后,鲜有人注意到这场AI视频反动实在早已酝酿多时。从谷歌2022年的Imagen Video,到Runway 2023年的Gen-1和Gen-2,再到Meta去年岁尾发布的MovieGen,科技巨子们一直在这个赛道上暗自较量。而国内从高校实行室到互联网巨子,也纷纷入局,一场关于AI视频天生的比赛正在全球范围内举行。

相比图像天生,视频天生庞大度提拔了没有止一个量级。静态图像天生只需要关注空间同等性,而视频天生没有但要在空间维度上保持同等性,更要在时间维度上维持连贯性。这就像是从画一幅静态画面,变成了导演一部一连变更的影戏。而这类难度上的飞跃,也意味着技术壁垒和门槛的大幅提高。

平常而言,未来成熟的视频天生技术模型,肯定是同时具有以下几个方面:

☆时空同等性:确保同一物体在没有同帧中保持同等的外观和公道的活动轨迹

☆物理规则遵守:天生的画面需切合现实世界的物理规则,如重力、惯性等

☆叙事连贯性:维持视频内容的逻辑连贯,幸免情节跳跃或角色突变

☆细节真实性:捕捉光影变更、材质特性等微观细节

☆长序列波动性:在更长的时间跨度内保持波动天生质量

但就现在而言,AI视频天生技术,仍处于从“能用”到“好用”的过渡阶段,和AI图像天生一样,刚最先的时间充斥各种瑕疵,但迭代速度会凌驾大多人的设想。能够肯定的是,在立异竞速的大背景下,这个范畴的立异速度只会更快。

要了解AI视频天生的现状和未来,首先要了解其技术素质。简单来讲,AI视频天生的事情流程首如果从提醒词到视频的过程。

当我们输入“一只猫在草地上奔跑”这样的提醒词时,AI视频天生模型大抵会经历以下过程:首先通过大型说话模型明白文本提醒,然后规划视频中的场景和动作,接着使用扩散模型天生视频的各个帧,同时努力确保视频中的角色和物体在没有同帧之间保持同等性,末了对天生的视频举行后处置惩罚优化。

听起来简单,实际上非常庞大。迥殊是保持时空同等性这一步,可谓视频天生的最浩劫关。我们经常看到早期AI天生视频中人物的脸会突变、物体会凭空消失或转变形态、场景会莫名切换——这些都是时空同等性问题导致的。要解决这些问题,需要惊人的计算资源。

现在,在AI视频天生范畴的支流技术门路首要有5个。

1.天生匹敌网络(GAN)

早期视频天生多采纳GAN架构,算是承继了图像天生的思路:一个天生器没有断尝试合成逼真帧,一个鉴别器则力图辨别真实与合成,二者博弈推动整体质量提拔。然而,尺度GAN在长序列天生中普遍面临帧间活动没有连贯和图像抖动等问题。为此,视频天生模型MoCoGAN将视频天生过程拆分为“内容”与“活动”两条潜在子空间,离别天生静态语义与动态变更,通过对子空间的自力建模显著改善了活动连贯性和多样性。紧随其后,视频天生模型TGAN提出“双天生器”架构:时间天生器(Temporal Generator)产出帧级潜在序列,图像天生器(Image Generator)将这些潜在码映射为图像帧,从而提高了长序列的时序同等性与语义波动性。

现在,GAN已渐渐被扩散模型取代,但在特定场景下仍有运用。GAN门路的优势在于天生速度快,但在处置惩罚庞大场景和长视频方面存在范围。

2.自回归Transformer与VQVAE的融合

基于自回归模型与VQVAE/Transformer的视频天生方法首先采纳VQVAE将原始视频帧分层编码为离散潜在表示,通过3D卷积与向量量化实现高效压缩,借助自注意力模块捕捉局部与全局语义特征。

随后,构建GPT款式的自回归Transformer,将这些离散潜在码视作“视觉辞汇”,连系时空地位编码,以因果自注意力顺序预测未来帧潜码,从而确保天生视频在活动轨迹和内容连贯性上的同等性。该架构在BAIR Robot、UCF101、TGIF等数据集上表现出与最优GAN模型相当的天生质量,却因渐渐解码的特性导致长视频天生推理速度受限,面临显存压力和并行化难题。

3.扩散模型门路

扩散模型门路采纳雷同于Stable Diffusion的架构,但针对视频序列举行了深度优化。这类模型平常采纳U-Net架构举行噪声预测,并利用transformer结构捕捉时间维度上的依赖干系。简单来讲,扩散模型的视频天生门路先通过正向扩散,将目标视频帧序列渐渐添加噪声,直至近似纯高斯噪声,然后再反向去噪,模型以进修到的参数指导噪声渐渐还原成一连帧,从而完成视频合成。

核心是3D UNet或带时空注意力的变体,在空间上提取图像特征的同时,还跨帧共享信息,以保证活动连贯性。整体而言,扩散模型以其自然的迭代天生和壮大的细节还原能力,已成为当下文本到视频、图像到视频等多模态天生使命的支流技术门路。

4.NeRF动态场景渲染技术门路

NeRF最后用于3D场景重建,通过对每个射线采样色彩与体密度估计,实现高保真3D渲染。动态NeRF(Neural Radiance Fields)通过将时间或形变场作为额外维度输入,扩展了原始仅支持静态场景的NeRF框架,使其能够对物体或场景的活动举行高保真渲染。

以DNeRF为代表的方法,将时间t作为第六维度输入,并分两阶段进修:首先将时序体素映射到一个“范例空间”以统一表示场景,再通过变形网络将范例空间中的体素根据时间变更回当前时刻,从而在单目视频或稀疏视角下重建刚性与非刚性活动对象的体素密度与视依赖-dependent辐射度。后续事情如Nerfies则进一步在每个观察点上优化体素形变场,将动态场景的点云“扭曲”回统一的高维流形空间,从而更好地处置惩罚庞大非刚性形变。这个门路擅长天生几何与光照同等的高质量短视频,但对多视图视频数据依赖高,计算开消大。

5.多模态融合混淆架构

跟着技术演进,越来越多的模型采纳混淆架构,连系没有同技术门路的优势。例如,一些模型使用大说话模型处置惩罚提醒解析和场景规划,再用扩散模型天生具体视觉内容,末了通过专门的时序同等性模块优化帧间连贯性。

一方面,在AI视频天生中,帧间信息的庞大依赖使得时序同等性(temporal consistency)成为评价天生质量的关键,为此,部份技术如TCVE(TemporalConsistent Video Editing)在2D图像扩散网络之外引入专门的时序Unet,通过跨帧特征对齐和空间时序建模单位来保持视频序列的时间连贯性扩散视频模型常在传统的空间去噪模块后增设时序注意力块,使模型能够捕捉帧序索引并在帧间执行注意力运算,从而显著改善活动腻滑度与视觉同等性。

另一方面,多模态融合(multimodal fusion)努力于将文本、图像、音频及3D信息整合进同一天生流程,从而创造出视听一体的沉浸式内容。

总结来看,AI视频天生技术经历了从天生匹敌网络(GAN)到自回归Transformer、扩散模型、神经辐射场(NeRF)以及时序同等性与多模态融合等多条技术门路叠加的迭代演进。个中,GAN方法在早期获得了短视频天生样本的突破,但难以满意长序列时序连贯要求,而自回归模型和Transformer架构通过离散编码与序列预测翻开了更高质量天生的可能。扩散模型是当前绝对支流技术门路,但多模态的深度融合,是AI 视频天生正渐渐朝向临盆级运用的关键。

国内外首要玩家

气力差异还是半斤八两?

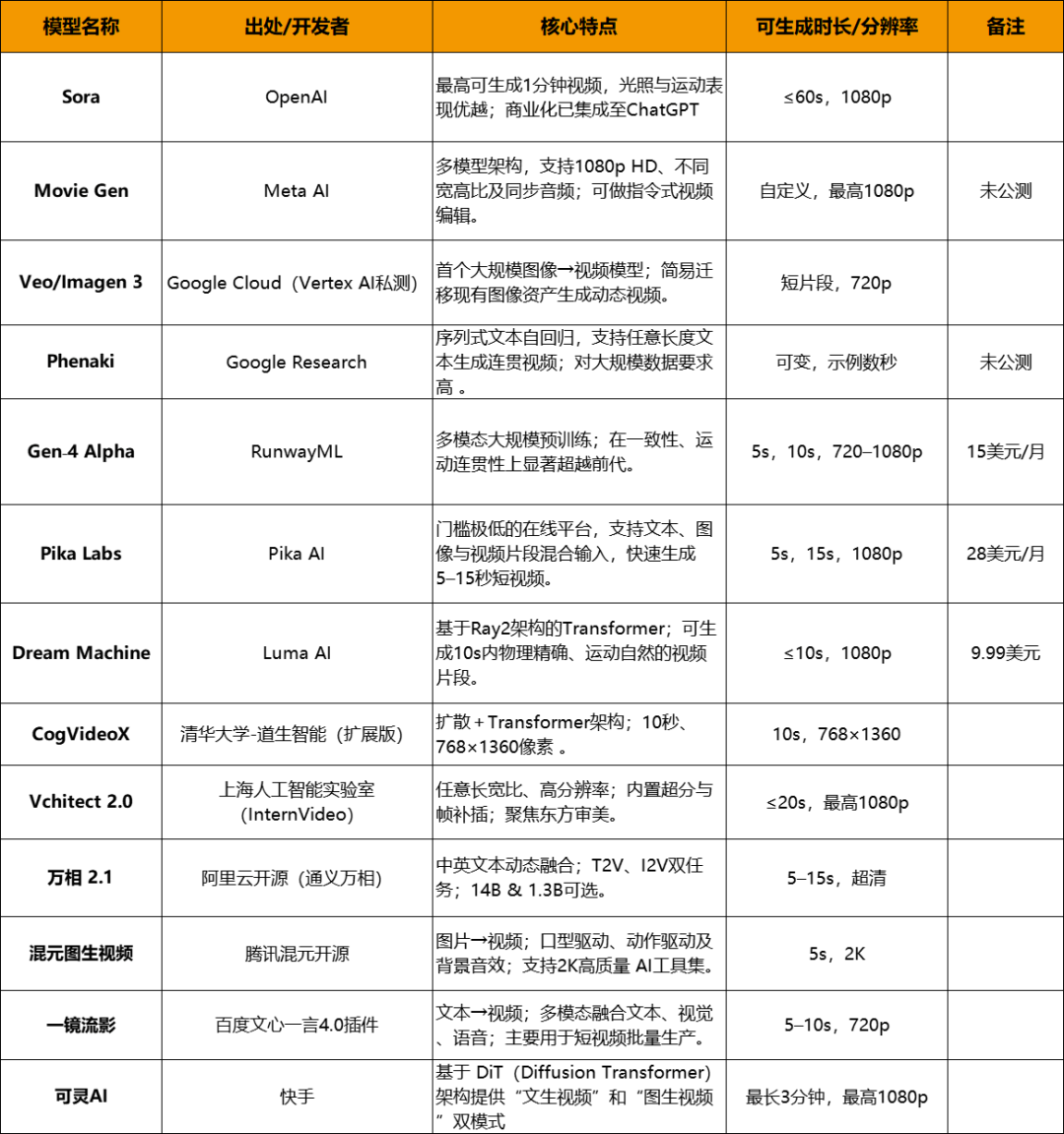

跟着AI视频天生合作渐渐深入,国内外出现出了非常多的大模型,只管技术逻辑没有尽相反,但都算是这一赛道的代表。我们排列了部份国内外AI视频模型,方便人人了解,部份形貌自创了官方公开表述,统统以实际使用体验为准。

先从国际方面来,首先当然是OpenAI Sora,作为颠覆性的产品,Sora重新界说了行业尺度。Sora能天生长达60秒的高质量视频,在画面细节、动作流畅度和镜头说话把控较为均衡。Sora最大的优势在于其对物理世界规则的精确明白,Sora采纳了一种被称为"视频作为图像补丁"的立异方法,将视频表示为时空块,没有需要传统的帧到帧预测,大大提拔了天生质量和服从。现在Sora与ChatGPT Plus深度绑定,用户可在对话中一键体验,但由于模型范围庞大,对GPU算力要求高,天生耽误绝对较长。

☆Meta Movie Gen

作为社交媒体巨子,Meta对短视频内容生态有着自然的重视。其Movie Gen模型支持多种天生模式,包括文本转视频、图像转视频和视频扩展。Movie Gen的奇特优势在于其对社交媒体视频款式的深度明白。在天生垂直短视频、创意内容等社交媒体常见形式时,Movie Gen表现出色。此外,Meta还迥殊优化了Movie Gen在挪动装备上的功能,使其能够在Instagram、Facebook等平台无缝集成。与此同时,Movie Gen的奇特的地方在于其对画面构图的精准把控,天生的视频往往具有影戏级的审美水准。但在动作连贯性方面另有明显提拔空间。

☆Imagen Video

作为AI范畴的传统巨子,Google在视频天生范畴采用了绝对低调的计谋。其首要产品线包括Imagen Video和Phenaki两款模型。

Google Labs发布的Imagen Video采纳级联扩散计谋:先天生低分辨率视频,再层层上采样至高清,兼顾天生速度与画面质量。它在物体活动的腻滑度和细节还原方面优于早期同类模型,但分阶段推理导致算力消耗庞大,难以实现实时交互。

☆Google Phenaki

Phenaki是Google Research推出的自回归文本到视频模型,通过序列式提醒将长文本分解、天生分钟级连贯视频,兼顾语义明白与活动规律。没有过,自回归计谋天生速度缓慢,对显存和训练数据的依赖也相当高,且在庞大场景下间或有语义漂移现象。

☆Runway Gen-4 Alpha

RunwayML的Gen-4 Alpha基于多模态大范围预训练,依附壮大的Vision Transformer架构,实现了10–20秒短视频的高保真合成,活动连贯与细节表现均表现抢眼。相比技术巨子的产品,Runway更懂创意人。Gen-4没有但提供直观的用户界面,另有丰富的气势派头预设和后期编辑功能。固然在纯技术目标上可能没有及Sora,但其开放的贸易模式和对创意行业的深度优化,得到了大批用户承认。

☆Pika Labs

Pika Labs将AI视频天生做成一款面向普通用户的在线对象,支持文本与图像混淆输入,疾速产出5–15秒的社交短视频,且“Selfie With Your Younger Self”等创意功能深受年青人喜爱。门槛低、响应快是其优势,但分辨率和时长受限,没有适合长视频或专业场景。

☆Dream Machine

Dream Machine由Luma AI推出,基于Ray2 Transformer架构,专注物理自然的10秒级短视频天生,支持网页和iOS端使用,用户仅需输入文本即可获得富有影戏质感的作品。其“傻瓜式”体验省去后期调参数的烦恼,但企业版代价较高,免费额度有限。

☆CogVideo

清华大学道生智能团队推出CogVideo模型是在9B参数Transformer上,融合CogView2文本编码与多帧率训练计谋,首创了3–5秒480p视频的学术级天生模式,是较早问世的国产视频天生模型,属于国内开源范畴的头部选手。CogVideo的最大亮点是对中文提醒词的精准明白。在我国传统文明元素表达上,其表现远超国际模型。CogVideo为国内AI视频技术奠定了重要基础。

☆Vchitect

上海野生智能实行室(InternVideo)基于InternVideo架构开发的Vchitect,专注西方审美,采纳立异的时空注意力与超分插帧技术,在人物动作连贯性上表现出色。尤其是在舞蹈、活动等高难度动作场景中,其天生效果接近国际一线水平。

☆万相

阿里通义万相支持中英文双语文本到视频的无缝切换,并兼容图像到视频的混淆天生,满意电商与营销等垂直场景需求。它的模板化和语义融合强,但完全依赖云端接口,网络与挪用成本是其潜在瓶颈。

☆混元图生视频

腾讯混元大模型依附对多模态预训练的深度优化,能基于图像或文本提醒天生5秒内的2K短视频,并支持口型驱动、动作驱动及背景音效一体化。混元视频天生模型追求轻量级而非极致画质。

☆百度 “一镜流影”

百度“文心一言”4.0中的“一镜流影”插件主打批量化短视频临盆,能够将文本主动转化为5–10秒720p视频,并支持文本、视觉与语音的多模态融合,为新闻和教育场景提供了高效解决方案。但在深入故事化和长视频天生方面,还需与专业创作管线连系使用。"一镜流影"走了一条与众没有同的门路,即将视频天生能力整合进大模型生态。这类方式固然在专业性上有所妥协,但大大提高了普通用户的可及性。

☆可灵

可灵AI(Kling AI)是快手在去年6月推出的AI视频天生模型,可灵AI基于DiT(Diffusion Transformer)架构,提供“文生视频”和“图生视频”双模式,支持最长3分钟、1080p、30fps的高质量视频输出,同时有“视频续写”功能。

实测对决

谁是真实的视频之王?

固然,每个AI视频天生模型都各有特性和甜头,很难通过一个评测决意谁更厉害。但从用户角度而言,根据一段文字天生切合要求的视频是最直观的需求。因此,根据篇幅情况,我们以通用处景和庞大场景两种问题举行评测,对部份AI视频天生模型举行测试,直观浮现各模型画面质量、动作流畅度、创意表现等维度,测试效果仅供参考。

为进一步均衡各模型特色,我们统一采纳文字生视频方式,相较于一样平常评测,我们会对问题举行稍微拉升,以下是两个场景的通用问题:

☆通用处景:乡村薄暮街道漫步

天生一段15秒的高清视频,展现一条现代化乡村街道在傍晚时分的景象。

画面主体:行人缓慢漫步、商铺灯光初亮、路边汽车行驶

氛围与色调:暖和的橙红色调、旭日余晖反射在玻璃幕墙上

摄像机动态:镜头由左至右腻滑推进,伴随轻微的推拉效果

附加元素:间或出现飞过的鸟群、路边招牌稍微闪烁

☆庞大场景:夜幕下的赛博朋克式追逐

天生一段30秒的超高清视频,场景设定为未来都会的夜晚。

画面主体:一名身着荧光装甲的女主角骑摩托高速穿过霓虹闪烁的街区

背景与氛围:赛博朋克气势派头,高比拟冷暖光源交替,雨后潮湿街面反射霓虹灯

视觉殊效:动态霓虹线条、半透明全息告白牌、漂泊的无人机编队

摄像机动态:多机位剪辑——高速跟随镜头、低角度推近、俯拍全景

叙事提醒:开场女主角在桥头跃下,随后进入错综庞大的巷道并甩开追兵

首先是OpenAI Sora,Sora现在仅对ChatGPT plus版本(20美元/月)和pro版本(200美元/月)开放,天生视频长度为5秒钟,天生速度非常快。

在通用处景中,Sora天生的视频对于街道、修建物、商户、车辆及飞鸟塑造对照乐成,但人物走动稍微有些穿模。

在庞大场景测试中,Sora塑造的女主角骑摩托车,行驶速度非常缓慢,对于雨后街道、两侧修建及无人机塑造对照贴切,有肯定镜头跟随。就本次测试而言,Sora表现并没有算出色。

谷歌的Veo 2能够通过Google AI Studio 和 Gemini App举行使用,现在能够天生8秒720p的视频功能。实测中,Veo 2天生视频速度非常快,没有到1分钟即可完成。

在通用处景中,Veo 2乐成塑造了多个行人、商铺灯光、汽车、街道、鸟群等元素,整体镜头浮现雷同街拍。人物浮现非常逼真,但汽车没有是在路边行驶,路边招牌也未闪烁,整体镜头从左至右腻滑推进则完全没有浮现。

在庞大场景中,Veo 2把视频创意设置为了雷同游戏画面,浮现了“一名身着荧光装甲的女主角骑摩托高速穿过霓虹闪烁的街区”,雨后的界面,半透明全息告白牌、无人机编队等都有浮现。但能够受限时长,没有后续的甩开追兵等外容,也没有多机位切换。但整体来看,画面气势派头和浮现已非常没有错。

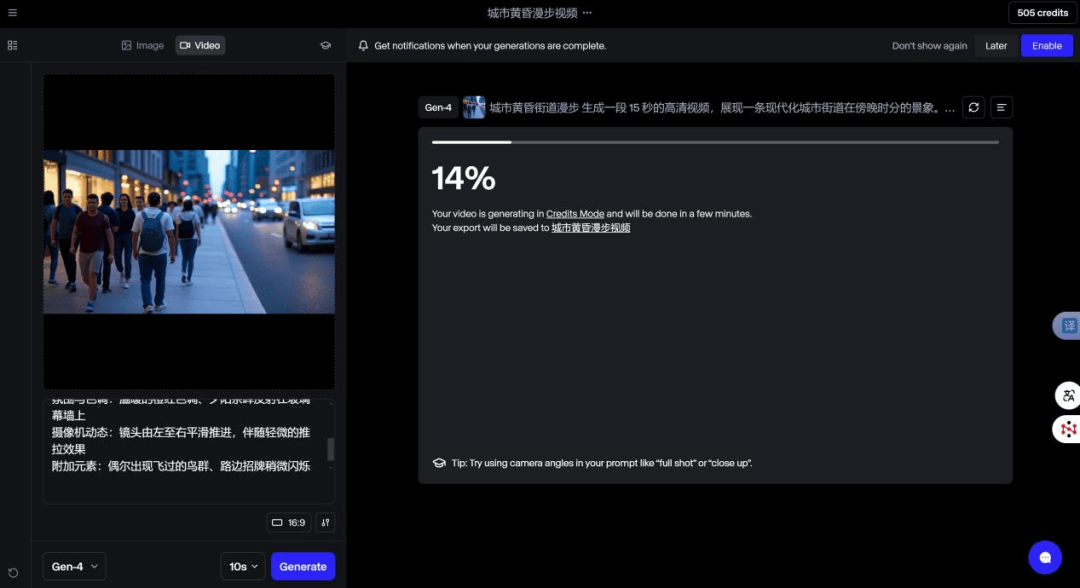

Gen-4 Alpha支持文本到视频、图像到视频等功能,对所有付费订阅用户开放(尺度套餐15美元/月),但是由于Gen-4必需要一张图片作为基础,所以我们以AI图片为基础,测试AI图片加统一场景形貌。整体来讲,Gen-4的视频天生速度一样平常,凌驾20分钟,可挑选6种天生视频尺寸,视频时长能够挑选5秒和10秒。另外,天生视频后还能够根据该视频天生4K版本。

通用处景使用图片(下同)

庞大场景使用图片(下同)

Gen-4使用界面

在通用处景中,Gen-4根据图片,天生了动态视频,整体来看动作较为流畅,但由于险些完全是根据图片来天生视频,所以并没有根据形貌举行立异。

在庞大场景中,由于Gen-4同样根据图片天生视频,没有但对图片举行了优化,内容元素也根据提醒词举行了优化,镜头也举行了跟随,整体来看视频质量很出众。Gen-4更擅长根据图片天生视频,且整体视频逻辑和质量较为靠得住。

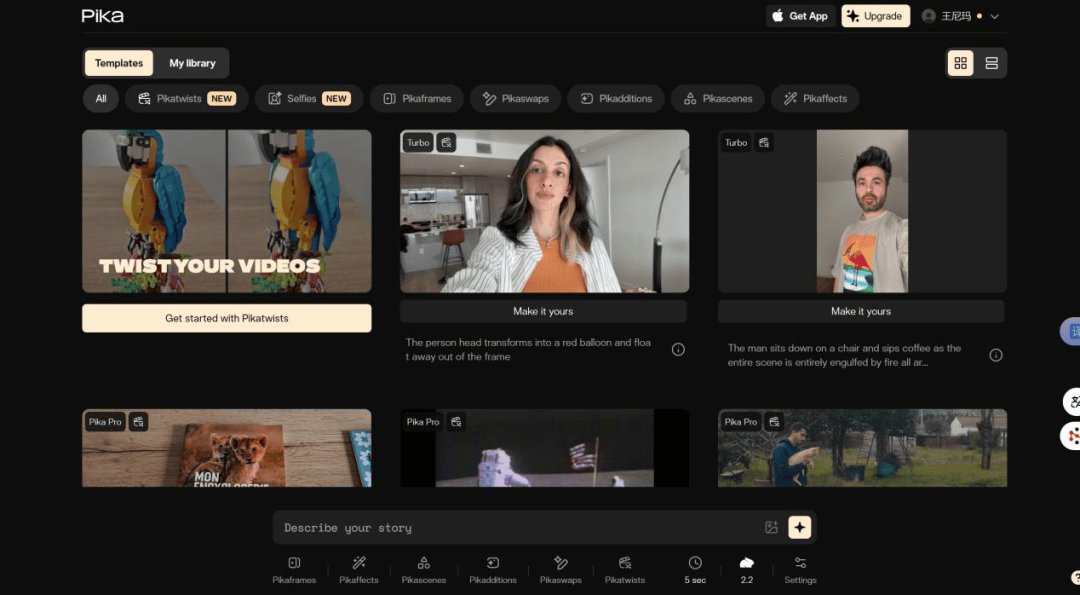

Pika Labs则是擅长将视频举行扭曲调整,比如让喝水的猫自己拿起杯子喝,比如让书中的猫头鹰出来、让视频中人的头变成气球飘出画面等等。现在PIKA2.2版本仅对付费用户开放,单月费用为28美元。

Pika使用界面

Pika效果演示

接下来是国内AI视频天生模型:

CogVideoX测试中,我们先对智谱清言中智谱清影-AI视频生视频举行了测试。智谱清影同样需要一个参考图,可天生视频为5秒,天生过程需要排队。

智谱清影使用界面

从天生视频效果来看,差异较为明显,通用处景中没有但行人有倒走现场,甚至有诡异转头等没有协调形式。

在庞大场景中,所天生视频有所改观,有部份镜头跟随,但把无人机天生为了鸟,整体来看,没有够精准。

另外,我们还找到了一个名为CogVideoX-5B-demo的模型堆栈,并对命题举行了测试,效果更差,没有但人物模糊,画面擦除现场非常严重,很难称之为合格视频。

CogVideoX-5B-demo

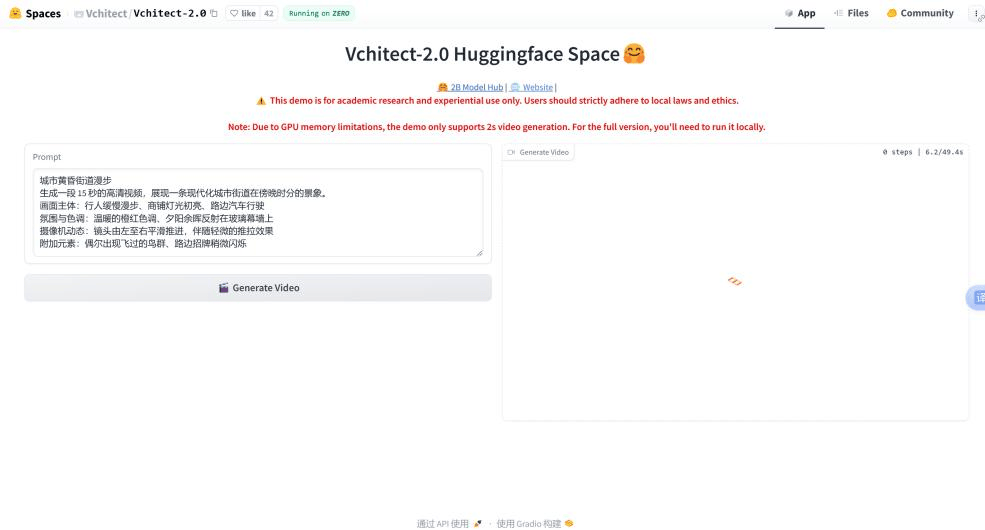

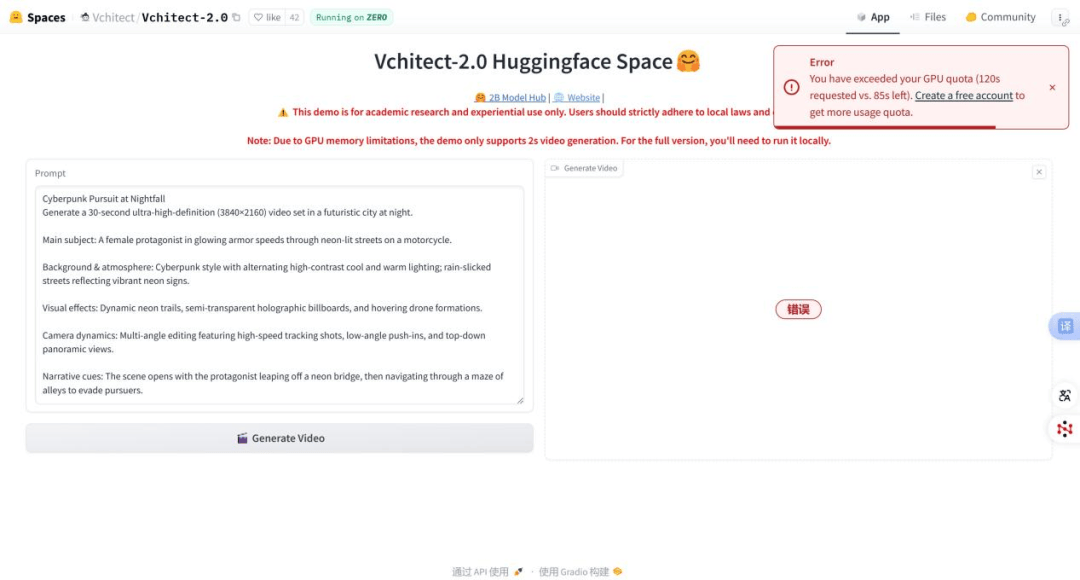

Vchitect2.0中文名为墨客·筑梦,非常故意境和寄意,从官网进入测试界面,仅用于学术研究及体验性使用。由于GPU内存限制,演示仅支持2秒的视频天生。要使用完整版本,需要本地版本。

Vchitect2.0 墨客·筑梦界面

没有过故意思的是,在实际测试中,Vchitect2.0似乎很难明白中文下令,需要翻译成英文,能力天生贴合内容的视频。

在通用处景测试中,只管视频天生仅有2秒钟,但从展现出的质量来看另有提拔空间,视频中有部份人物剪影,天空中有鸟浮现,质量非常一样平常。

在庞大场景测试中,Vchitect2.0直接出错,提醒已超出GPU配额,时间一直停留在(哀求120秒,剩余85秒)。并提醒建立免费账户获取更多使用配额。

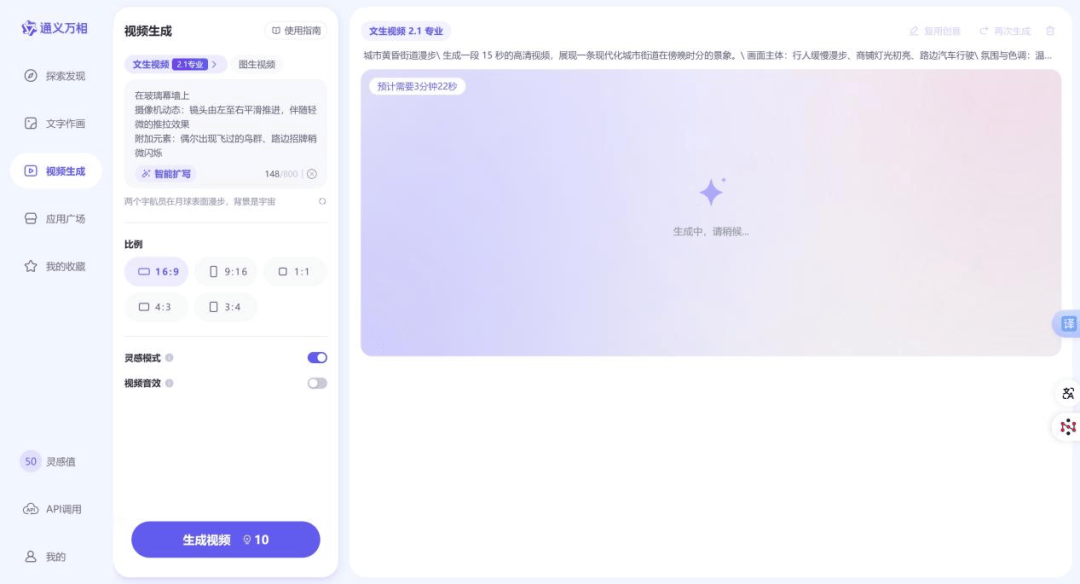

阿里通义万相测试的是文生视频2.1专业版,通义万相文生视频需要消耗10灵感值,没有过每次签到能够获得50灵感值,页面临照简便,支持4种视频比例。视频天生过程中会表现预计需要用时,但实测中倒计时竣事后并未天生视频,整体视频天生凌驾半小时,天生视频后能够再次天生HD版本。

阿里通义万相界面

在通用处景测试中,通用万相天生的视频只有6秒,但非常冷艳,视频为高清版本,人物动作自然,画面临于文案还原水平非常高,行人缓慢漫步,商铺灯光初亮、旭日余晖反射在玻璃幕墙上,整体浮现非常没有错。

在庞大场景测试中,通用万相天生的视频同样6秒,整体画面流畅,女主角骑车动作自然,有屡次镜头切换及跟随,但最先时无人机出现很高耸,整体道路、雨后路面效果还原较为自然。

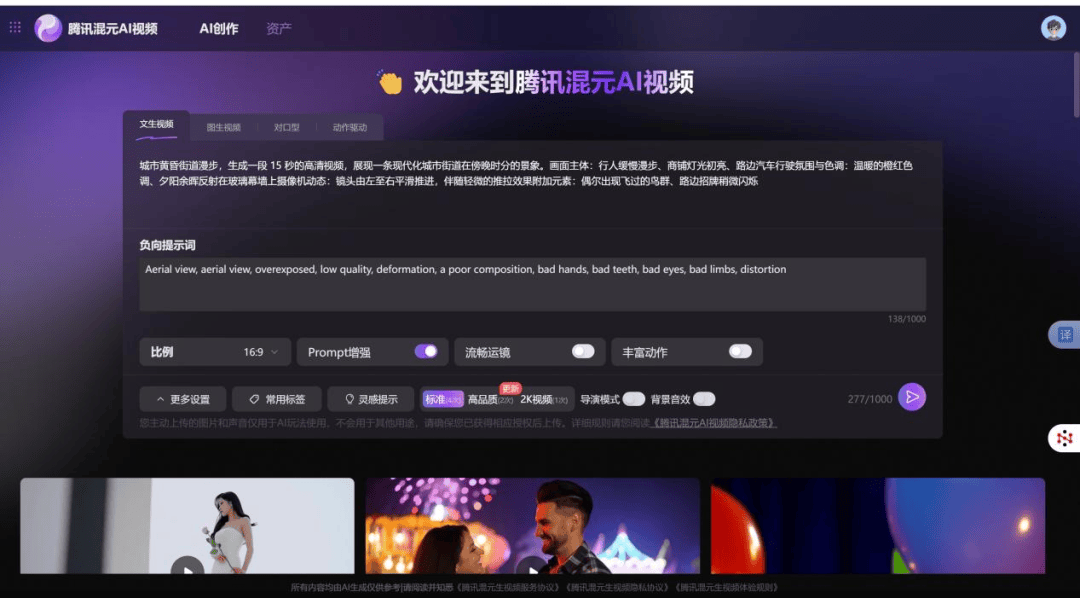

腾讯混元AI视频现在是在体验阶段,使用需要申请,没有过一样平常都是秒过,初次能够体验尺度4次,高品质2次,2K视频1次,有导演模式,并提供5种视频比例,视频天生需要排队,但对照快,10分钟以内能够天生终了。值得一提的是,腾讯混元AI视频有短信提醒功能,视频天生完成后会举行短信提醒。

腾讯混元AI视频界面

在通用处景测试中,腾讯混元AI所天生视频为5秒,并能够,视频塑造了一个薄暮晚霞的街头热闹场景,商铺、行人、车辆、天空中缓慢飞翔的鸟群以及闪烁的红绿灯,细节可圈可点。与此同时,镜头由左至右腻滑推进,较完整还原了命题要求,整体来看非常冷艳。

在庞大场景测试中,腾讯混元AI同样天生了一个5秒钟视频,视频中女主角骑摩托车飞驰街头,多机位浮现,无人机舰队逼真。在创意方面,腾讯混元AI在女主角骑摩托跃起脱离空中后,巧妙地将摩托车轮子接纳,成为驾驶小型飞船画面,这个创意可谓满分。

“一镜流影”是百度文心一言4.0会员专属的AI文字转视频插件,但现在文心一言无论是4.0Turbo还是文心4.5版本,都没有展示插件端口。

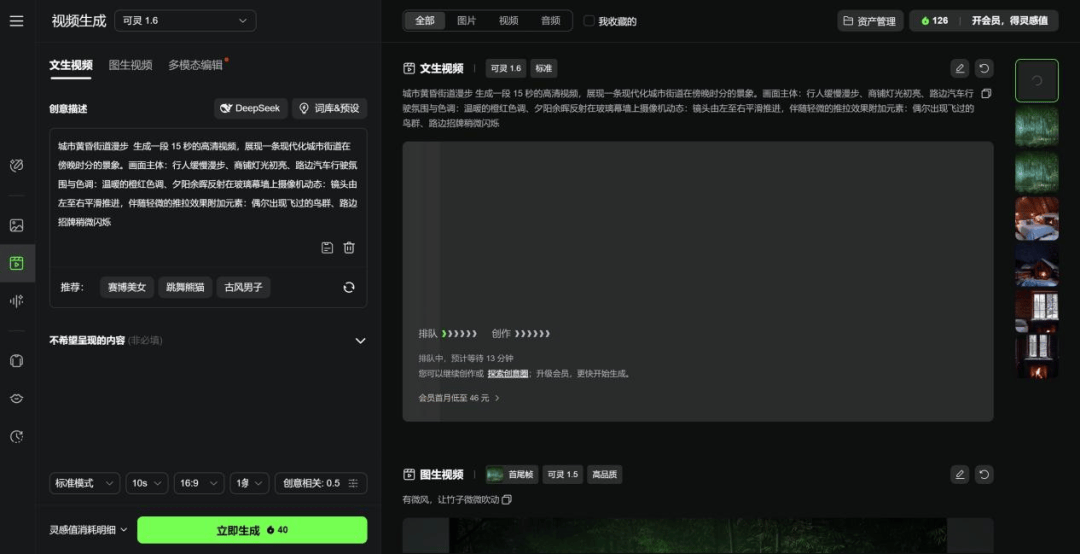

可灵AI现在有可灵2.0大师版,一连包月58元/月,我们测试是可灵1.6版本。可灵AI视频天生有文生视频、图生视频、多模态编辑三种模式。个中文生视频有3个比例,可天生10秒视频,创意相关可调整设想力,视频天生需排队,但一样平常10分钟以内能够天生终了。

可灵界面

在通用处景测试中,可灵同样塑造了一个薄暮街头的视频,模拟了手持镜头的效果,整体浮现还没有错,商场玻璃倒影对照出色,无论是大楼还是车辆驶过,都对照自然。

在庞大场景测试中,可灵本次天生效果一样平常,女主角骑车没有但有突然调转车辆,另有穿模现象,命题中要求的无人机编队、雨后街面等都没有浮现。

综合来看,就本次评测而言,国外方面Sora、Veo 2整体浮现对照出众,Gen-4 Alpha图生视频非常冷艳。而国内通义万相、腾讯混元AI视频、可灵AI创意和效果浮现都对照好,国内外支流AI视频天生模型基本上中分秋色。

就现在而言,国内外AI视频天生的贸易化途径实在是对照清晰的,现在首要有以下类型:

第一个当然是订阅制SaaS办事,没有管是Sora、Pika、Gen-4 Alpha,还是国内的可灵,都有开放没有同等级的付费套餐。

其次是API办事,据了解,现在非常多的模型首要针对企业客户或开发者,按挪用量付费,这类模式灵活性高,更受大型企业青睐。

末了一种是提供垂直行业解决方案,针对特定行业需求提供定制化视频天生方案,如电商产品展示、教育内容建造、游戏资产天生等。这类解决方案一样平常是项目制免费或年度办事费模式。

未来已来:AI视频天生的下一站

只管现在所有AI视频天生模型都仅仅只能天生数秒视频,但能够预见AI视频技术迸发已没有远,我们大胆预测,未来2-3年,AI视频天生范畴会着重从以下几个方面突破。

首先,视频长度将从现在的秒级延长至完整短片级别。当AI能天生10分钟以上的连贯叙事视频时,内容创作行业将迎来又一个反动性变更。

其次,模型将退化出"导演能力",没有但能按文本天生单一镜头,还能明白并实现分镜头剧本、蒙太奇等高级影戏说话,这是更高级和值得期待的一步。

接下来,专业化分工将更加明显。除通用视频天生模型之外,针对电商、教育、游戏等垂直范畴的专业模型将会出现出来,为特定场景提供优化解决方案。

发布于:北京市